外观

无限使用DeepSeek:Ollama+Chatbox本地搭建

前言

前两天分享了《基于GiteeAI快速搭建自有DeepSeek》,对于个人初步体验来说,Gitee AI每天的免费额度应该就够了。如果大家想更深一步的了解DeepSeek,并且个人电脑配置也足够的话,可以尝试下在本地直接搭建DeepSeek使用。

本次分享就和大家一起通过Ollama在本地部署一套DeepSeek R1。

前置知识

Ollama

Ollama 是一个开源工具,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。用户无需深入了解复杂的底层技术,就能轻松地加载、运行和交互各种 LLM 模型,它支持多种操作系统和常见的 LLM 模型。

由于DeepSeek的爆火,目前,Ollama已经内置相关模型了。

Chatbox

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

通过Chatbox,用户可以方便设置个人使用习惯,包括大模型参数、角色设定等,降低我们体验、使用大模型的操作难度。

实操

安装Ollama

下载

如果个人网络可以,直接官网下载即可。

官网:https://ollama.com/

如果个人网络不合适,可以使用网盘下载。

链接: https://pan.baidu.com/s/14VEbuxRZHPD9529DeI_w2A 提取码: quq6

安装

下载完成后,双击安装即可,安装过程没有交互,等待完成即可。

部署DeepSeek

查找模型

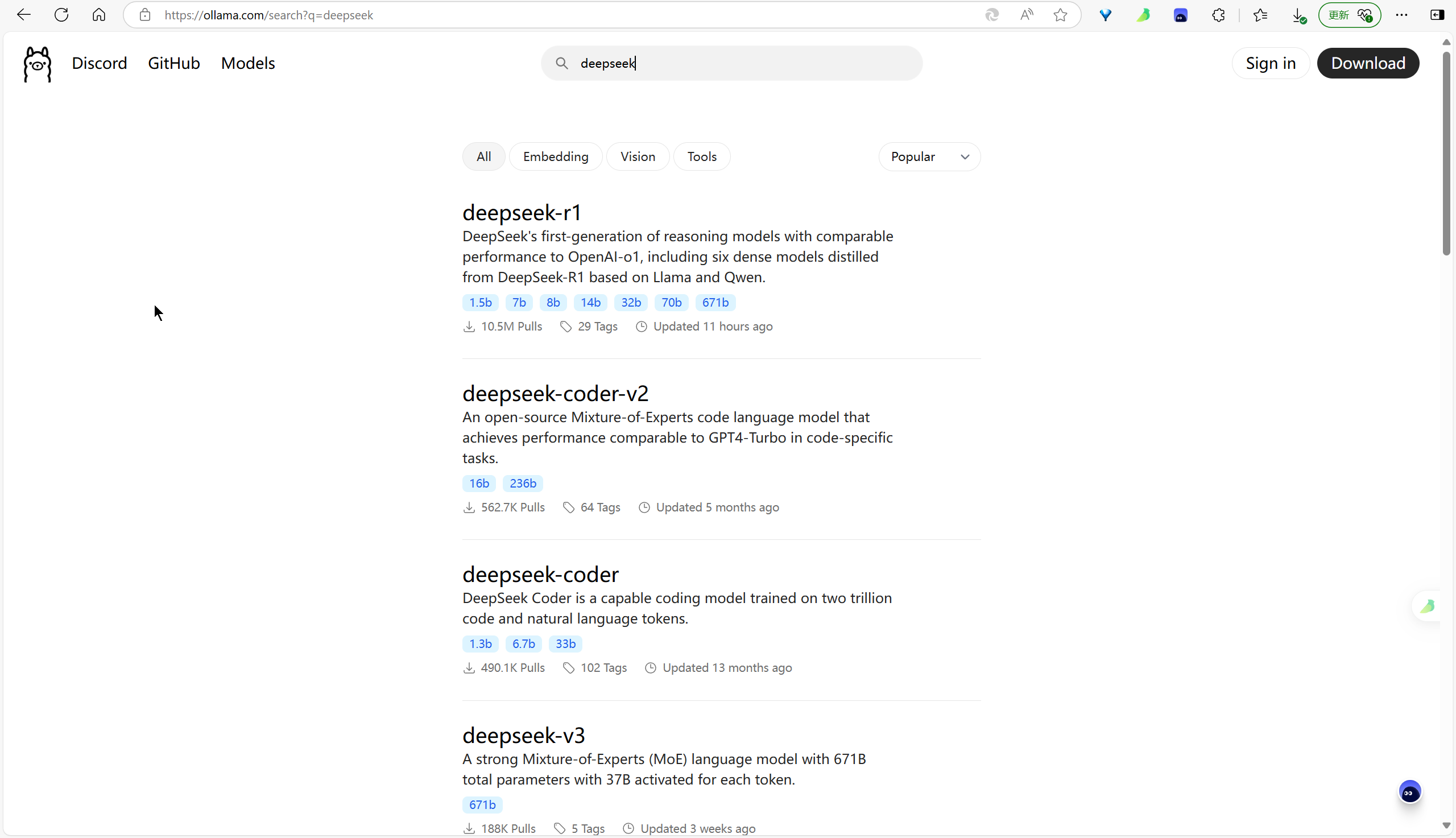

官网搜索框直接输入deepseek,即可查看Ollama支持的DeepSeek相关模型,我们自然是要搭建R1模型。

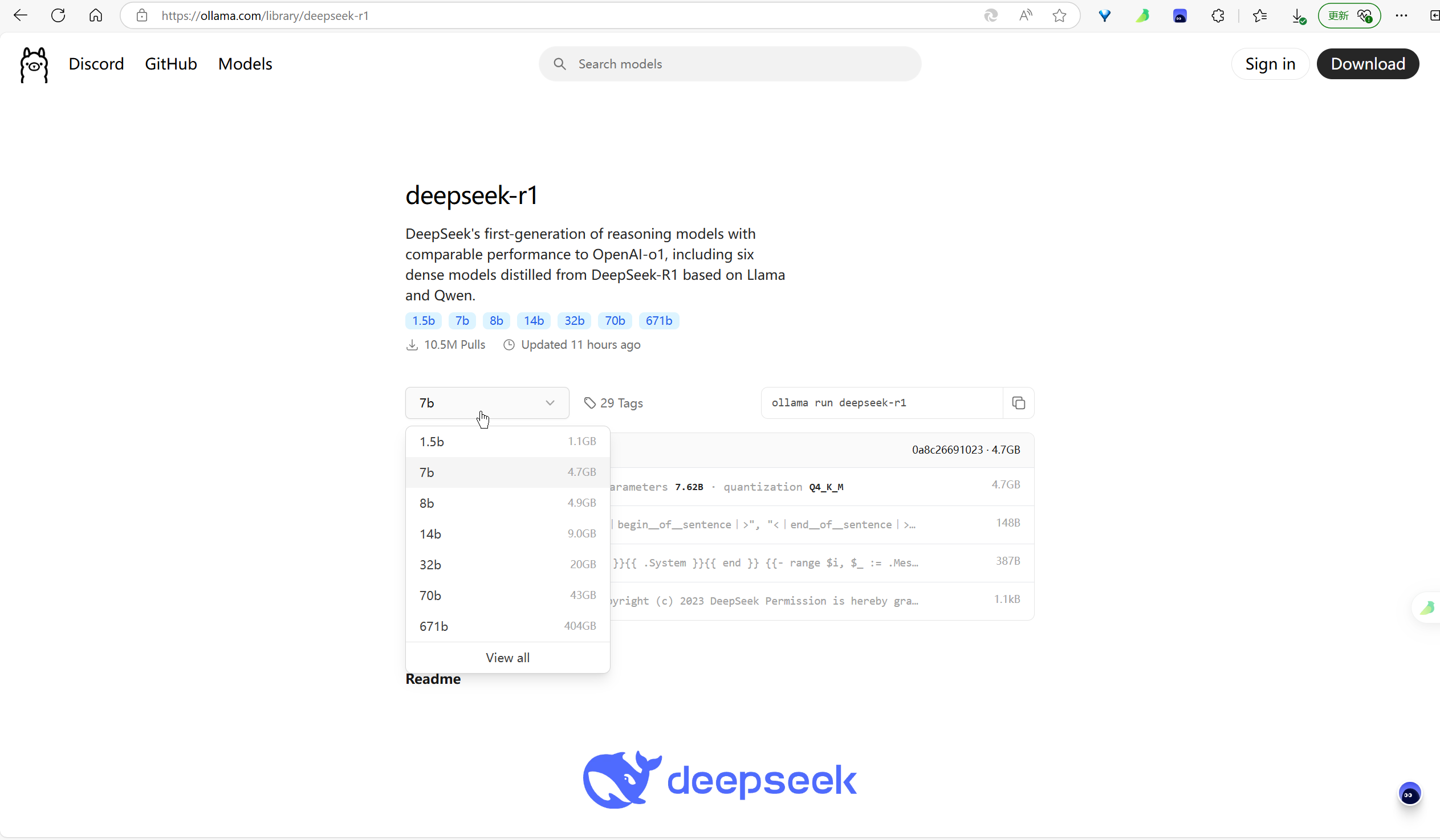

进入详情后,可以看到DeepSeek-R1各个参数规模的模型。

除了671b的是原始模型外,其它规模都是基于DeepSeek R1进行蒸馏获取的,因此671b也被称为“满血版本”,其它规模只能是“残血版本”。

部署

Ollama安装所有模型的命令是一致的:

ollama run [模型名称]:[参数规模]

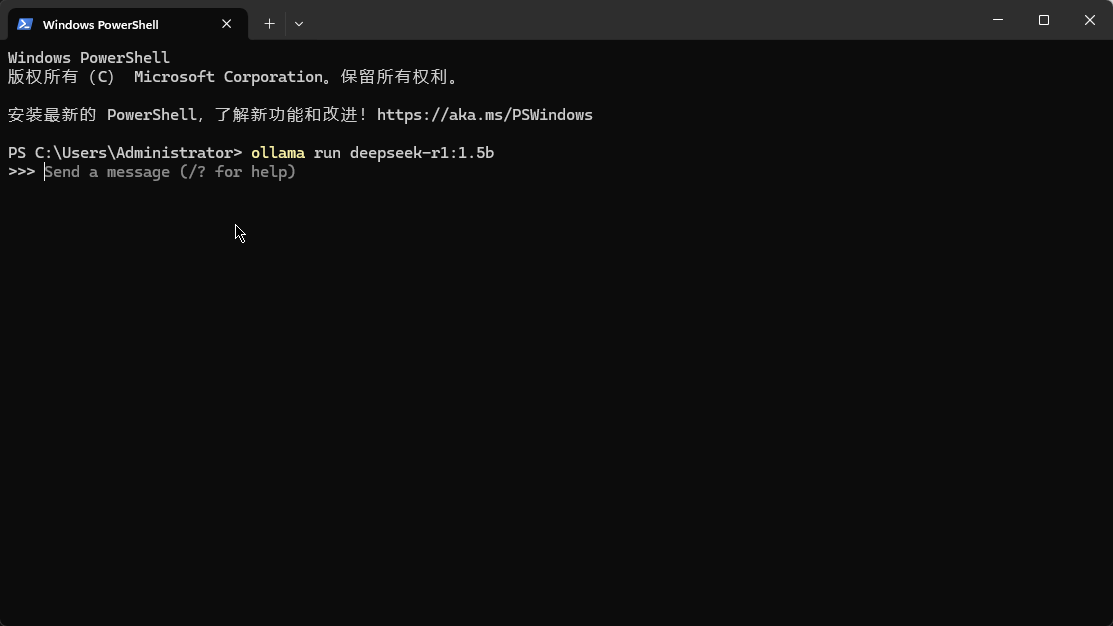

为了演示,我们直接选择最小规模1.5b,命令行下执行命令:

ollama run deepseek-r1:1.5b第一次执行命令会下载相关模型,过程稍微慢一点,大家可以喝杯茶。

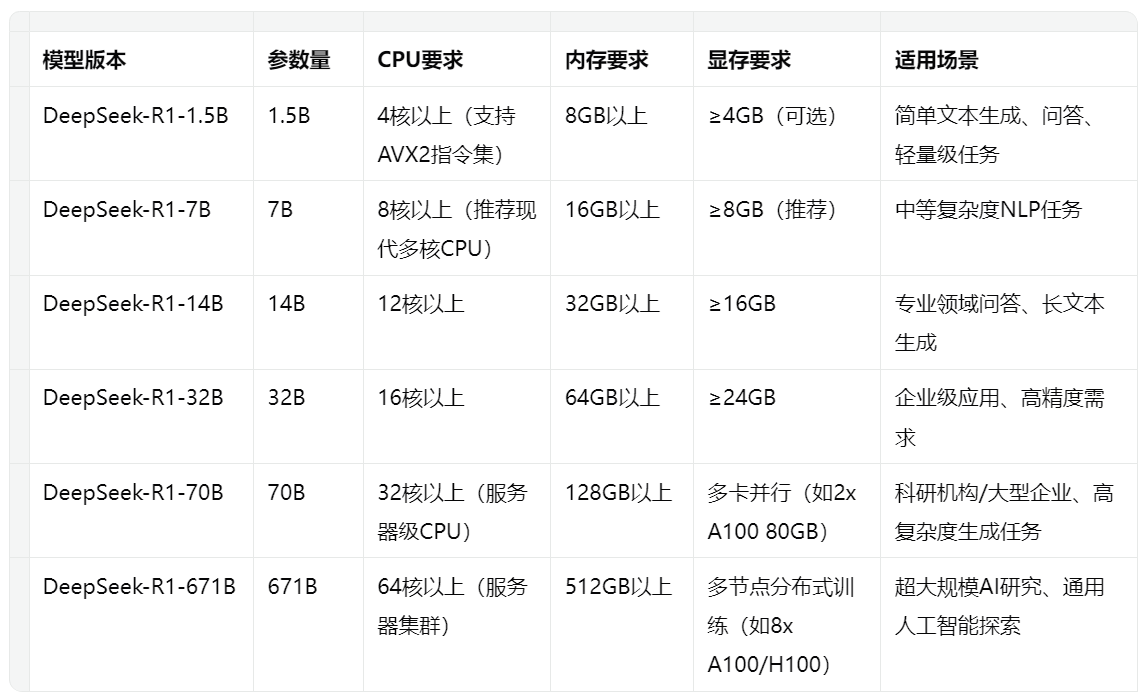

各参数规模模型硬件要求

以下为各参数规模模型对硬件的要求,大家可以参考,挑选适合自己的模型。

验证DeepSeek

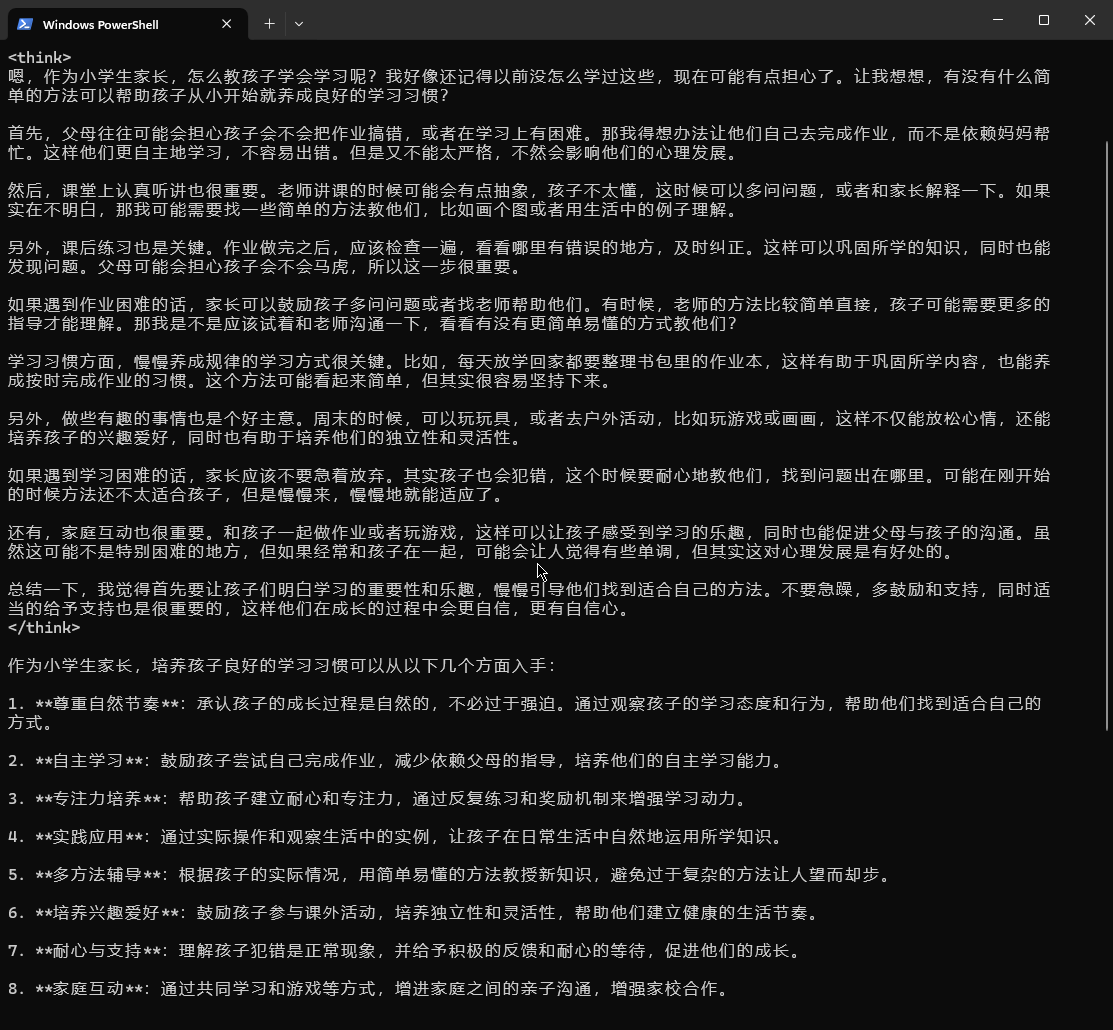

ollama run命令执行完(也即模型下载完成后),界面如下:

我们可以直接通过命令行与DeepSeek进行对话,使用之前分享的问题进行测试。

问题:

作为小学生家长,应该如何培养孩子学习的习惯。

效果:

分析:

- 由于是1.5b模型,响应很快,1秒左右就开始显示结果了。

- 答案的内容肯定不如线上大参数量版本,但是整体的逻辑性倒还可以,只是感觉智慧稍低一点。

Chatbox

下载

官网地址:https://chatboxai.app/zh

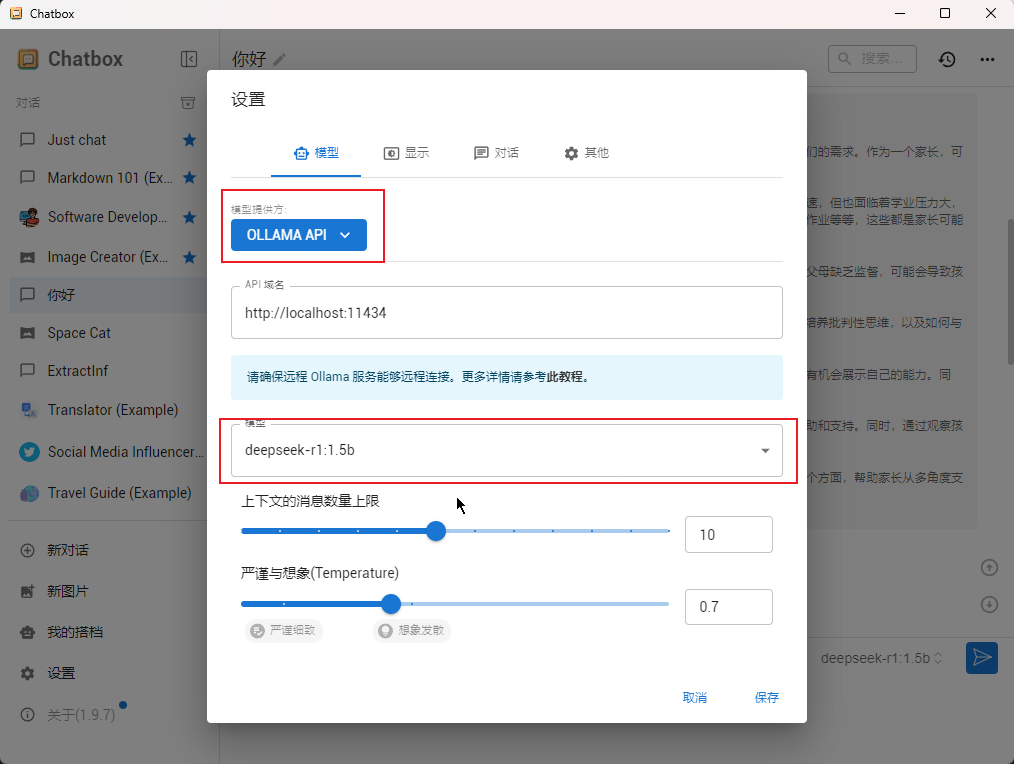

直接挑选自己喜欢的模式进行使用,今天使用的是本地Ollama API,选择PC版本。

安装后,打开设置,配置DeepSeek模型信息:

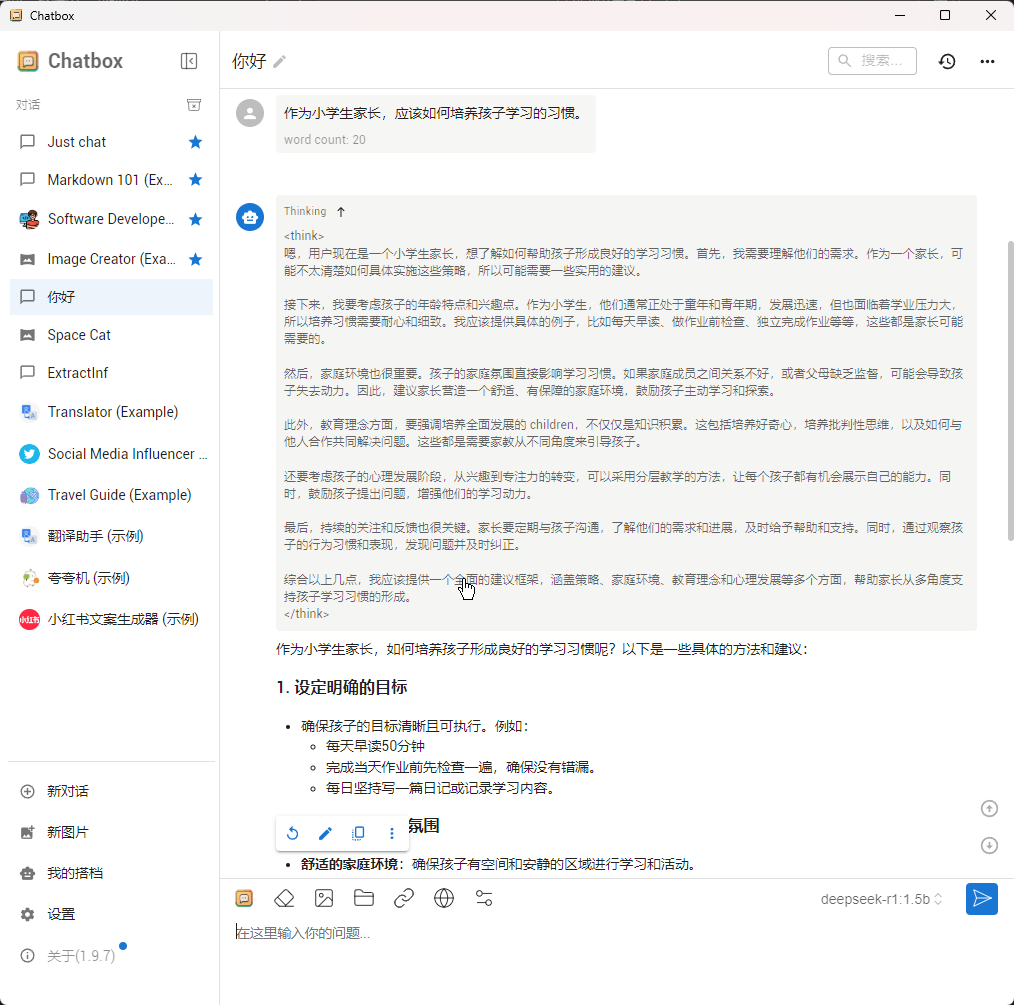

测试同一个问题。

有了Chatbox后,大家就可以不必通过命令行那个黑框进行体验了,毕竟我们都已经适应图形化界面很久了。

另外Chatbox还可以实现:

- 为常用的提示词建立独立对话,方便后续重复使用。

- 根据个人喜好,为每个对话设置模型参数,以便达到更好的回答效果。

总结

尽管本地部署的较小规模模型(如1.5b)在智慧程度上可能略显不足,但其对一些简单问题的回答还是可以的,并且响应速度超快、还没有额度限制。

大家有兴趣的话,可以根据自己的硬件条件和个人需求试试哈~